20/04/2025 13:58:50

Microsoft giới thiệu mô hình AI '1-bit' chạy mượt chỉ với CPU

Trong khi phần lớn các mô hình AI hiện nay dựa vào các con số phức tạp 16 hoặc 32-bit để lưu trữ và xử lý thông tin, Microsoft lại chọn hướng đi táo bạo với một mô hình cực kỳ đơn giản: chỉ dùng ba giá trị trọng số là -1, 0 và 1. Mô hình mới mang tên BitNet b1.58 vừa được công bố bởi nhóm General Artificial Intelligence của Microsoft, hứa hẹn mang lại hiệu suất đáng ngạc nhiên mà chỉ cần chạy bằng CPU thông thường.

Gọn nhẹ nhưng vẫn mạnh mẽ

Với cấu trúc được gọi là “1.58-bit” – tương ứng với số bit trung bình để biểu diễn ba giá trị số (-1, 0, 1), BitNet b1.58 là một trong những mô hình học ngôn ngữ tự nhiên đầu tiên được huấn luyện theo cách tối giản ngay từ đầu. Khác với các phương pháp "giảm nhẹ" sau huấn luyện, vốn thường làm giảm hiệu suất mô hình, BitNet được thiết kế nguyên bản để hoạt động hiệu quả ở mức trọng số tối thiểu.

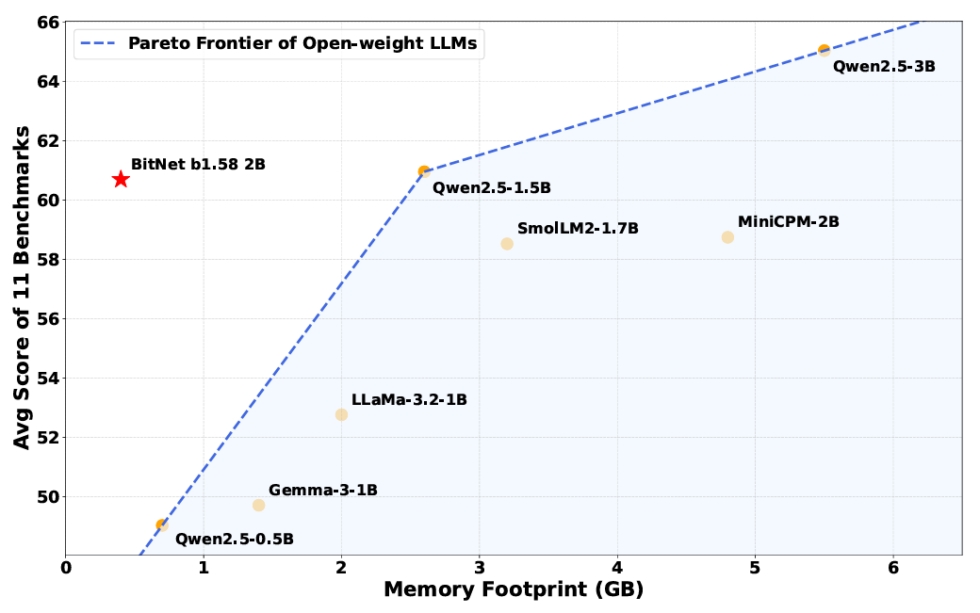

Dù chỉ sử dụng 0.4GB bộ nhớ – ít hơn nhiều lần so với 2–5GB của các mô hình tương đương – BitNet vẫn đạt kết quả gần ngang bằng với các mô hình "full precision" khi thực hiện các bài kiểm tra suy luận, toán học và kiến thức nền.

Tiết kiệm năng lượng, chạy mượt bằng CPU

Nhờ cấu trúc trọng số đơn giản, BitNet b1.58 không cần các phép nhân ma trận phức tạp – yếu tố tiêu tốn nhiều tài nguyên trong các mô hình AI lớn. Thay vào đó, mô hình chủ yếu sử dụng phép cộng, giúp tiết kiệm đến 85–96% năng lượng so với các mô hình truyền thống.

Với lõi tính toán được tối ưu hóa riêng cho BitNet, mô hình này có thể chạy với tốc độ 5–7 token mỗi giây – gần bằng tốc độ đọc của con người – ngay trên CPU như Apple M2, mà không cần GPU.

Bạn đọc có thể tự tải về và thử nghiệm BitNet b1.58 trên CPU ARM hoặc x86 qua bản demo trực tuyến được Microsoft cung cấp.

Tương lai của AI không cần siêu máy tính?

Dù BitNet b1.58 mới chỉ là mô hình 2 tỷ tham số được huấn luyện trên 4.000 tỷ token, các nhà nghiên cứu tin rằng đây là một minh chứng cho khả năng phát triển các mô hình AI hiệu quả hơn rất nhiều về mặt chi phí và năng lượng.

Tuy chưa rõ chính xác vì sao mô hình đơn giản như vậy vẫn hoạt động tốt, các nhà nghiên cứu khẳng định đây là hướng đi đáng để đầu tư, nhất là khi chi phí phần cứng và năng lượng đang ngày càng tăng cao với các mô hình AI "ngốn" GPU.

Trong tương lai không xa, rất có thể những mô hình nhỏ gọn như BitNet sẽ là chìa khóa đưa AI đến gần hơn với mọi người, mà không cần đến các siêu máy tính đắt đỏ.